当前位置 鱼摆摆网 > 创业 > 网络营销 >

卷积神经网络是什么?

作者:鱼摆摆 2019-12-27 16:481基本概念

卷积神经网络是什么

神经网络(Artificial Neural Networks , ANNs)是模仿动物网络行为特征,进行分布式并行信息处理的算法数学模型。

卷积神经网络(Convolutional Neural Networks , CNN)是一类包含卷积计算且具有深度结构的前馈神经网络,是深度学习的代表算法之一。卷积神经网络具有表征学习能力,能够按其阶层结构对输入信息进行平移不变分类,因此也被称为“平移不变人工神经网络”

卷积神经网络可以做什么

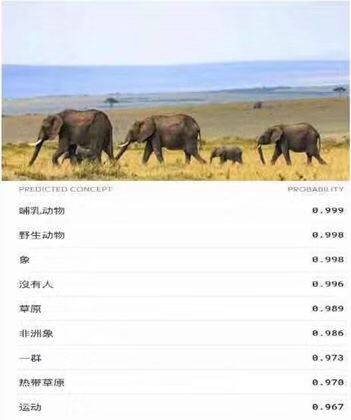

目标分类

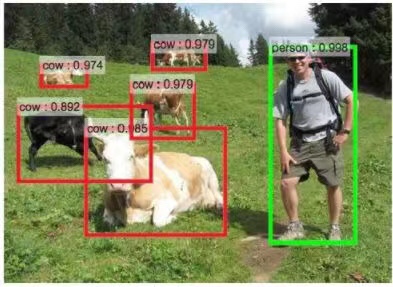

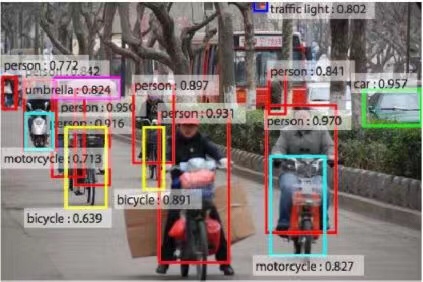

目标检测

目标分类与目标检测

目标分类不需要定位

目标检测需要定位出物体的位置,且把所有图片中的物体都识别定位出来

2

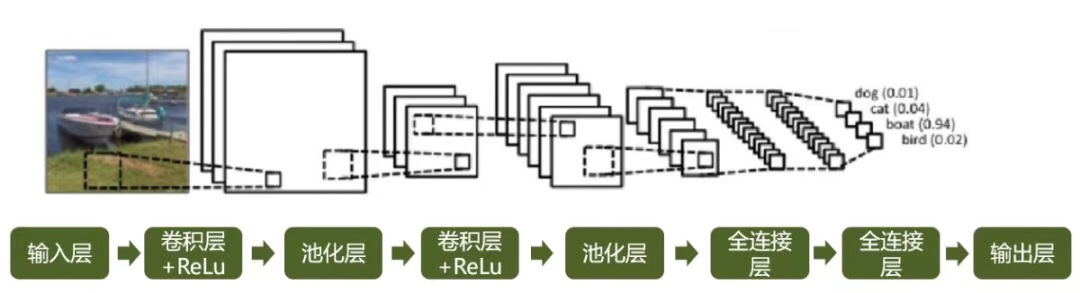

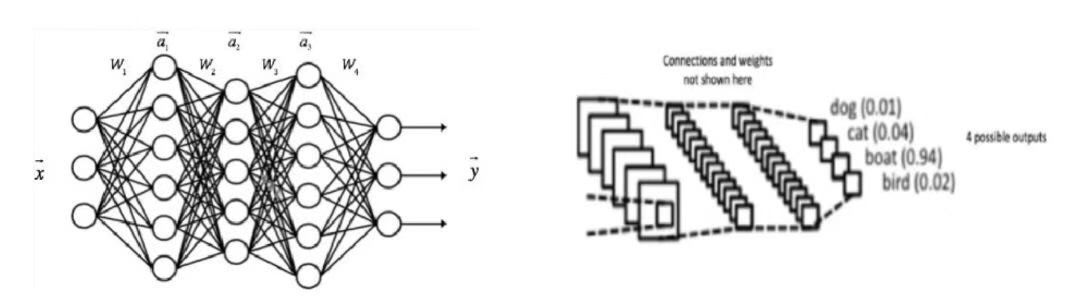

一个完整的CNN

把图片分入四个类别:狗、猫、船、鸟

当输入一张船的照片时,船的权重是最高的,所有权重加起来等于1

卷积神经网络主要执行四个步骤:

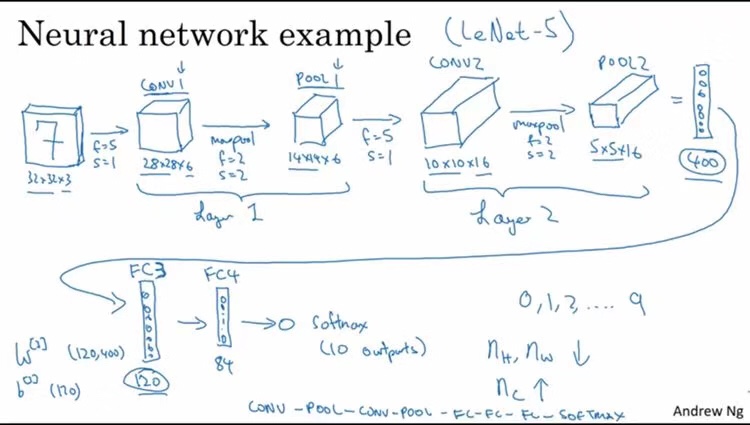

卷积

非线性(Relu)

池化或下采样

分类(全连接层)

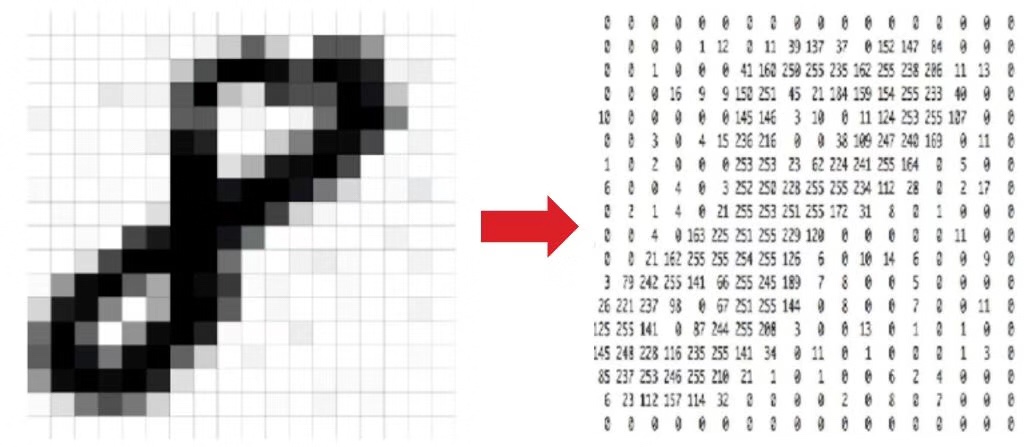

基本单元——输入层

二维图片(灰度图像):可以表示为像素值组成的矩阵,在0-255之间;而且只有单通道

三维图片(色彩图像):有三个通道—RGB,可以想象成三个2d矩阵叠在一起,每个矩阵的值都在0-255之间

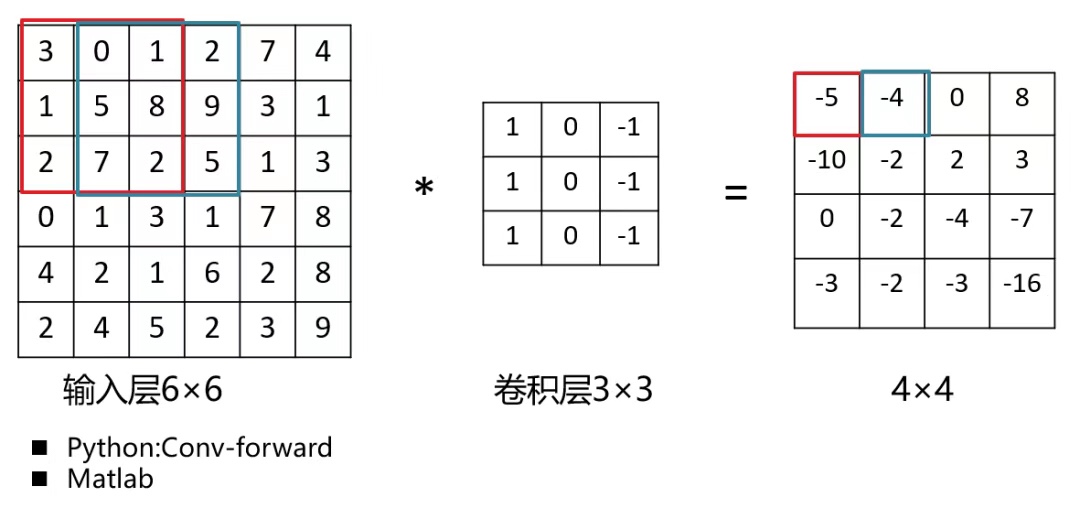

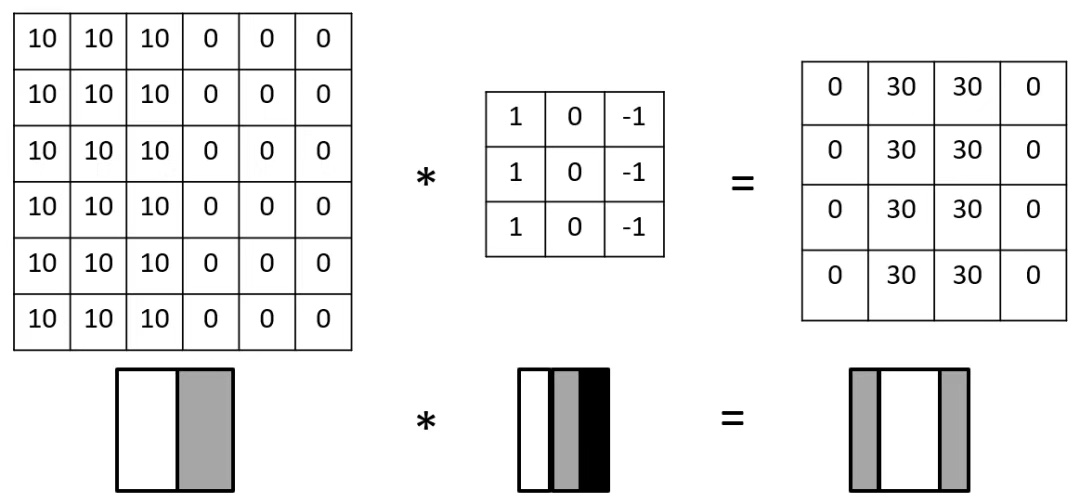

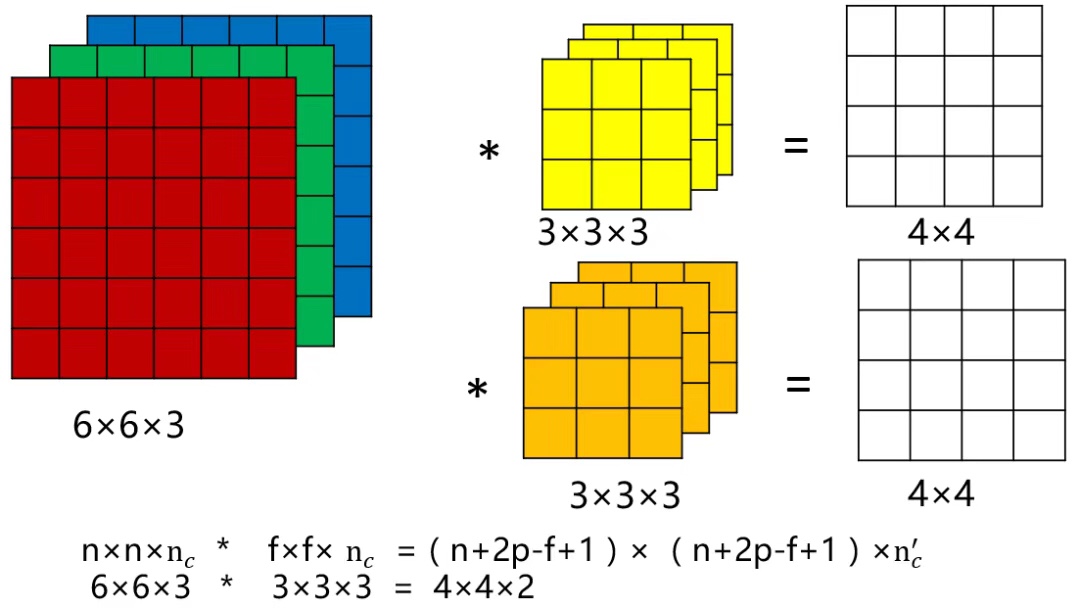

基本单元——卷积层

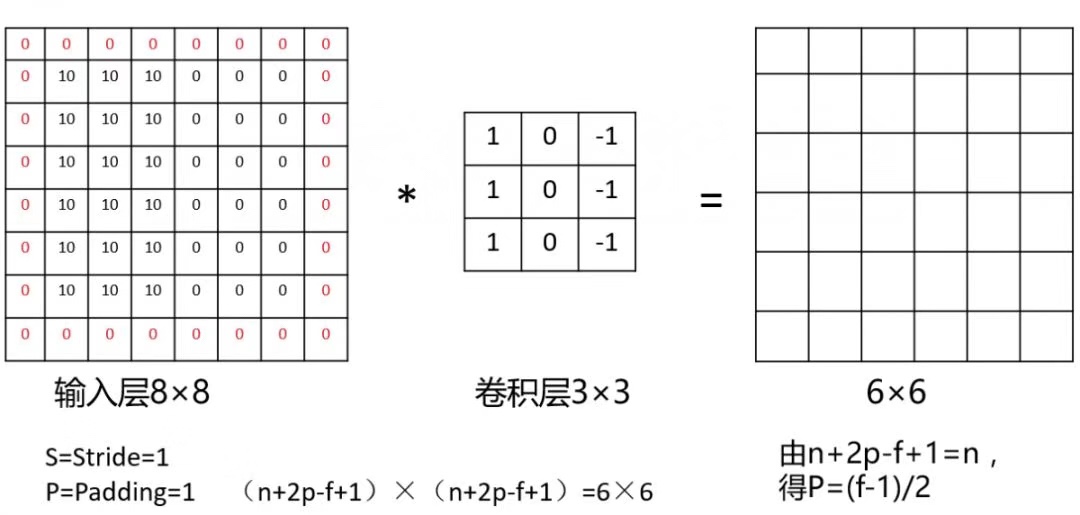

边缘检测

边缘识别

Padding

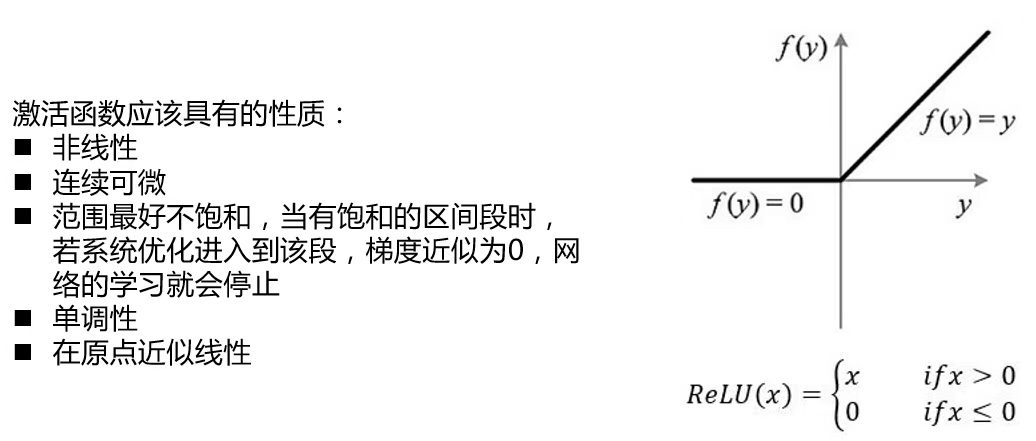

基本单元——激活函数Relu

激活函数的作用:神经网路中,激活函数的作用是能够给神经网络加入一些线性因素,使得神经网络更好的解决较为复杂的问题

Relu的优点

由于X>0时导数为1,所以, ReLU能够在X >0时保持梯度不衰减,从而缓解梯度消失问题。

计算速度非常快,整个过程的计算量节省很多

Relu会使一部分神经元的输出为0,这样就造成了网络的稀疏性,并且减少了参数的相互依存关系,缓解了过拟合问题的发生

Relu的缺点

随着训练的推进,部分输入会落入硬饱和区,某些神经元可能永远不会被激活,这个ReLU单元在训练中将不可逆转的死亡,导致相应的参数永远不能被更新,使得数据多样化丢失。这种现象被称为“神经元死亡”

偏移现象。即输出的均值恒大于零。偏移现象和神经元死亡会共同影响网络的收敛性

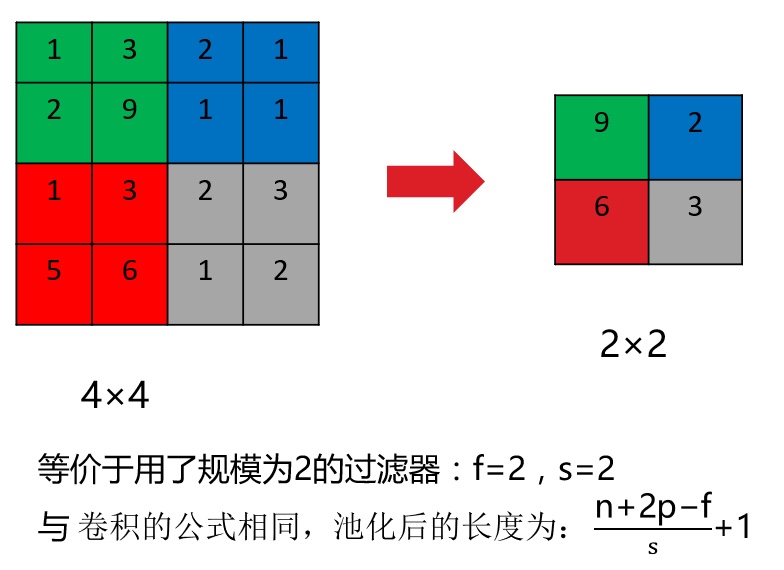

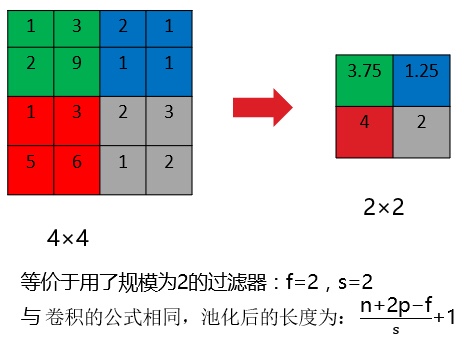

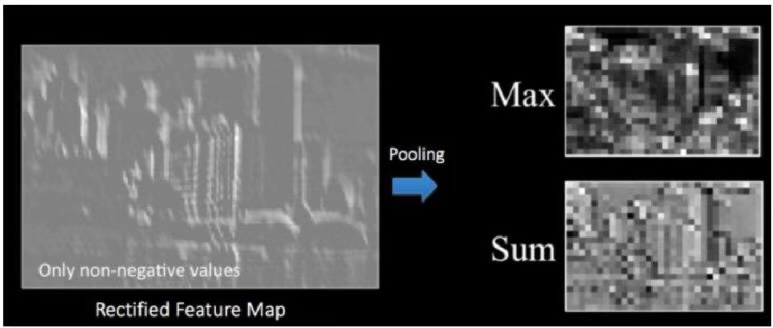

基本单元——池化层

Max pooling

池化原因:

缩减模型的大小,提高计算速度 ;

提高所提取特征的鲁棒性

Average pooling

池化过程没有需要学习的参数,执行反向传播时,反向传播没有参数适用于池化,所有参数都是手动设置的,所以池化是计算神经网络某一层的静态属性

将池化操作施经过卷积层和ReLU激活函数上特征映射结果

基本单元——全连接层

使用softmax激励函数作为输出层的多层感知机;

全连接层表示上一层的每一个神经元,都和下一层的每一个神经元是相互连接的。

卷积层的池化层的输出代表了输入图像的高级特征,全连接层的目的就是类别基于训练集用这些特征进行分类。

除了分类以外,加入全连接层也是学习特征之间非线性组合的有效方法。卷积层和池化层提取出来的特征很好,但是如果考虑这些特征之间的组合,就更好了。

3神经网络例子

- 全部评论(0)